Dockerを使用したAirflowのローカル環境構築【Airflow】

データエンジニアのモリヤスです!

仕事でAirflowを使用するとのことになったので、触ってみたいと思います!

今回の記事ではそのためにローカルの環境構築をDockerで行ってみました。(公式サイトの内容になります。)

目次

今回試してみた環境

- Airflow : 3.1.3

- Mac OS(Intel)

- Docker : 24.0.2

- Docker Compose : 2.18.1(2.1.4以降である必要があるそうです)

- Docker Desktop

- VSCode

※Airflow コンテナが適切に実行させるために、少なくとも4.00GBのメモリを使用するようにDockerの設定をした方が良いそうです。設定方法はこちらの記事をご覧ください。

※今回作成する環境は本番環境での使用を想定して設計されていないそうなので、ローカル環境でAirflowの勉強や試すことのみに使用してください。

構築方法

docker-compose.ymlのダウンロード

Airflowの環境作成ための既存yamlファイル次のコマンドでダウンロードします。

curl -LfO 'https://airflow.apache.org/docs/apache-airflow/3.1.3/docker-compose.yaml'Airflowプロジェクトの初期化

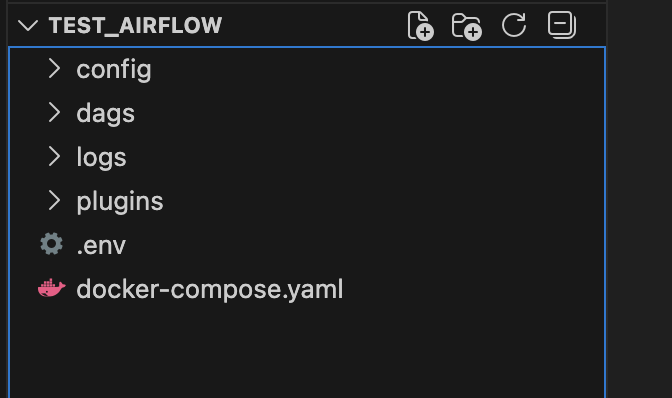

任意の場所、任意の名前で問題ありませんが、今回のAirflowのプロジェクトを作成します。

僕はDeskTopにtest_airflowというディレクトリを作り

- ディレクトリ内にdocker-compose.yamlを移動

- 下記コマンドを実行

をしました。

mkdir -p ./dags ./logs ./plugins ./config

echo -e "AIRFLOW_UID=$(id -u)" > .env下記のよう画像のようになっているはずです。

データベースの初期化

次のコマンドで実行します。

docker compose up airflow-init色々なメッセージが出てきて、初期化の最後に下記のメッセージが出てくれば完了です。

test_airflow-airflow-init-1 exited with code 0Airflowを起動する

ではAirflowを次のコマンドで起動させます。

docker compose up起動ができたら「http://localhost:8080」にアクセスしてみます。

次のような画面が出ればOKです。

UsernameとPasswordはともに「airflow」でSign Inでき、次のような画面になるはずです!

終わりに

いかがだったでしょうか?

手軽に環境構築が可能だったのでびっくりですね!

これでAirflowと遊べるようになったので、色々試していきたいと思います!

参考記事

- Running Airflow in Docker — Airflow 3.1.3 Documentation

- メモリ不足でエラーになったのでDockerのメモリを上げた #Docker – Qiita